现在论坛的开源程序让搭建一个论坛甚至可以在几分钟就可以完成,但是后期论坛优化问题却是一个持续长久的问题。最近我也在尝试搭建一个论坛,学习一下论坛的运营管理方面的知识,在优化论坛的过程中,发现论坛的重复收录现象很严重,经过实践和研究,现在论坛的重复收录现象已经得到很好的解决,今天就把解决论坛重复收录问题给大家分享一下。

第一招解决办法:伪静态URL路径

最近在一个论坛发布外链的时候,通过查自己网站的外链相关域发现,一个帖子竟然被重复收录了6篇网页,这样的网页在经过搜索引擎的去重结果,时间久了就造成网站外链数量的不稳定,对于论坛主来说,页面收录重复,权重和收录量都会受到影响。

如何解决这样的重复收录现象呢?

通过观察URL路径问题,我们以discuz论坛做介绍,当然phpwind程序也是一样的。

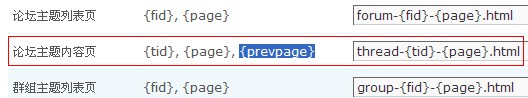

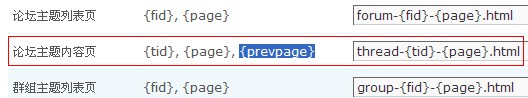

打开论坛后台管理中心>全局>seo设置>URL静态化中“论坛主题内容页”有“{prevpage}”它的意思是列表页翻页的页码,因为我们发布的帖子并不可能一直在第一页,经过其他帖子的发表,一篇帖子很快就沉到第二页或者第三页。这样一个帖子的URL是经常变动的。这就会造成上图中收录重复的现象。而解决办法就是将“{prevpage}”在URL中删除即可。看修改后的截图:

第二招解决办法:利用robots.txt屏蔽

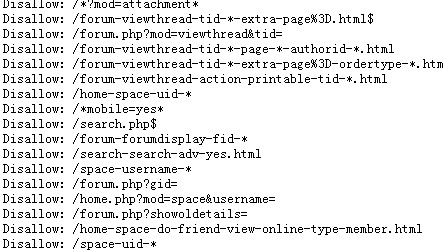

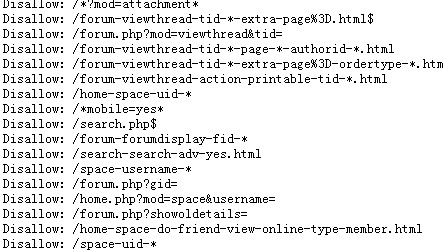

论坛的程序也会生成一些动态的链接,这些动态链接和伪静态的页面是重复的,同样需要屏蔽掉,这时我们就可以利用robots.txt来进行了。通过搜索引擎对动态链接的收录在robots.txt中添加相应的屏蔽字段。修改后的部分截图如下:

上面两点技巧足以解决论坛的重复收录现象,针对第二种方法大家可以参考笔者的论坛设置,通过利用disallow命令对动态URL链接的屏蔽,这样的动态链接可以很好的屏蔽掉,通过百度对论坛的收录查看,百度并没有收录一条动态的链接,通过实践也证明了百度是遵守robots.txt文件协议的。

如果大家对论坛程序解决重复收录现象有更好的办法,可以和王继顺交流,大家一起学习进步,seo技术是需要不断的实践和摸索出来的,解决网站的重复收录现象对内页排名的影响较大,这样可以集中内页权重,同时也稳定了论坛的收录,我们又何乐而不为呢?

关键词:重复收录